陶建华_学术观点丨清华大学陶建华教授:大模型技术的演进与启示

文 / 陶建华

1 大模型时代的到来

人工智能大模型是指通过预先在海量数据上进行大规模训练,而后能通过微调以适应一系列下游任务的通用人工智能模型,被看作是一项人工智能技术迈向通用智能的里程碑式进展。传统上,人工智能模型往往依赖大量有标签数据,而且一个模型一般只适用于单一场景,人工智能的研发和应用成本高,场景适应能力弱。近十年来,人工智能模型的参数量正在迅速变大,仅仅2021—2022年间,模型参数量增加了10倍以上,以 Transformer 预训练为基础的大模型,可以通过“大规模预训练+微调”的模式,在无标签数据上进行学习,降低了对标注数据的要求,不仅使模型的性能相较于以往人工智能方法带来了突破性提升,而且随着数据量增大和模型的进一步变大,模型的性能还会不断增强,甚至出现量变到质变的能力变化。

从大模型的发展历程来看,在“大数据+大算力+强算法”的加持下,人工智能大模型进一步通过“提示+指令微调+人类反馈”方式,可以实现一个模型应用在很多不同领域。到GPT-3时甚至可以不用做微调,也可以一个模型完成多种不同的任务,展现了很强的自然语言生成能力和通用性。大模型因此被喻为就像PC时代操作系统一样,成为各种人工智能应用的关键基础模型,可引导形成人工智能应用开发的新范式。大模型解决了过去人工智能应用的碎片化问题,以往一个模型只能做一件事情,而现在通过一个大模型即可以实现更多的任务。

2 大模型技术的前世今生与未来

人工智能大模型最初是从语言模型发展起来的,是为了解决语言的特征提取问题。在早期统计机器学习时期,自然语言处理常用Ngram等语言模型;而在深度神经网络时期,为了解决特征的表征,使其能在深度神经网络里得到有效训练,最早提出了Word2vec词向量方法;为了进一步利用深度神经网络挖掘文本中的上下文关系,进一步提出了循环神经网络或卷积网络的特征提取方式。2018年,Google提出了一种基于 Transformer架构的双向预训练语言模型(BERT),它采用多层Transformer架构注意力机制,可以挖掘文本中任意词之间的关系,从而可以建模更加复杂和长距离的语义关联信息,相对于循环神经网络,这一模型还解决了大规模并行化训练的难题。Google提出的这种预训练语言模型,实质是一种填充式的机制,而与 Google提出的填充式预训练语言模型发展思路所不同,OpenAI公司则选择了另一条发展路径,即生成式自回归语言模型(GPT系列)发展模式。研究表明,GPT模型更容易适应下游任务,具有更强的通用能力。ChatGPT正是基于GPT系列的生成式自回归语言模型而发展出来的。

以往自然语言处理在处理文本中词与词之间的关系时,往往难以对长距离词间关系进行有效建模,而且文本中各个语义单元相对独立,缺乏高层语义之间的相互联系。大模型用Transformer注意力机制不仅能够挖掘文本中任意词相互关联关系,还能够挖掘长距离高层次语义关联信息,因而大模型能够更有效获取知识和知识关联,这为大模型能够进行高性能的内容生成提供了重要基础。

从GPT模型的发展历史看,GPT-1主要是实现了基于Transformer架构的自回归预训练语言模型初始版本,其特点是可利用大量无标注数据进行无监督预训练,在不改变基座模型的情况下,仅通过对少量标注数据进行任务相关的输入变换,然后进行有监督微调就可以适用于不同的下游任务。到GPT-2时,模型和参数规模变得更大,其特点是通过Zeroshot Learning的方式就可以使模型适用于不同的下游任务,使大模型展现出了一定的通用性,但性能依然有限。到GPT-3,模型规模和数据规模达到千亿量级,能够在没有任何梯度更新和微调情况下,仅通过提示词或少数样例即可以很好地完成指定的各种不同任务,性能甚至超过当时最好的专用模型。GPT-3可以从大量信息提炼出超脱语义的信息,包括语义片段的信息,以及一些各个语义层次之间的关联信息,但其缺点就是会输出无用、有害信息,且无法对齐人类的偏好。因此,在GPT-3之后,OpenAI公司还提出一种InstructGPT模型,它采用了有监督微调和人类反馈的强化学习RLHF方法,使得模型能够更好地遵循用户的意图,生成的内容和人类的喜好进行有效对齐。ChatGPT则是在GPT-3.5基础上发展而来,GPT-3.5在GPT-3的基础上加入了代码、思维链和多轮对话数据进行训练,代码和思维链的训练使得模型具有更强的逻辑推理能力,同时,ChatGPT也采用了InstructGPT的强化学习和微调模式,这一系列的优化形成了ChatGPT很强的语义理解、多轮对话和较为通用的问答能力。

2023年3月OpenAI发布了多模态人工智能大模型GPT-4。GPT-4具有更强的文本和图像理解能力,允许输入文本长度达到历史最长,且允许用户定制模型的风格和行为,在很多任务上达到人类水平,有时甚至超越人类表现。

目前,大模型技术已应用于很多场合,如:微软已将GPT-4整合到其office套件中,打通各个办公软件,实现智能化的协同办公;同时将GPT-4整合进Bing搜索引擎,以GPT-4+搜索的方式实现了更加直接和智能的信息获取方式,显著提升了获取信息的准确性、可靠性和综合性。

人工智能大模型以其很高的性能和多种任务的通用能力,将会建立一种人工智能应用的新范式,极大改变人类社会的生活和生产模式,其典型应用场景包括:

• 大模型+传媒。大模型可以帮助实现智能化新闻整编,提升新闻的时效性,将传统劳动性的新闻采编工作自动化,更快、更准、更智能地生成内容。

• 大模型+影视。大模型可以极大地拓宽影视创作素材,可以根据大众的兴趣量身定制影视内容,从而更有可能吸引大众的注意力,获得更好的收视率、票房和口碑。同时大模型可以为剧本创作提供新思路,激发创作者的灵感,开拓创作思路,缩短创作周期。

• 大模型+营销。大模型可以打造虚拟客服,助力产品营销。

• 大模型+娱乐。大模型可以加强了人机互动,增加互动的趣味性和娱乐性,激发用户参与热情。

• 大模型+军事。大模型可以增强军事分析和决策能力,实现快速准确的作战评估、作战任务规划和执行、战术决策支持、改进态势感知等。

事实上,大模型的应用场景远远超出上述范畴,在社会、经济、安全、医疗、健康等各个领域都将会发挥重要作用,它的发展给人类带来了非常强大的助推力,让数字世界和现实世界的共生变得更为便捷、更为有效。

3 大模型技术存在的问题与对策

尽管大模型技术对人工智能应用起到了重要推进作用,但其依然存在一系列关键问题。首先是大模型的可信性问题。目前,大模型的主要应用侧重于人工智能内容生成(AIGC)领域,其生成的内容虽然符合语言规范,流畅性和逻辑性都很好,但内容的真实性经常存在问题,现有大模型技术尚不具备对所生成内容可信性的评估能力。其次是大模型的可解释性问题。大模型本质还是深度学习的进一步延伸,其很多能力和机理依然缺乏有效解释。

针对大模型的可信性问题,目前已有一些探索性的工作,如:通过一些正向推理或者反向验证方法实现自我验证,通过正向推理生成侯选的内容,再通过反向验证,来进一步验证生成的内容是否满足条件。通过正向推理和反向验证方法不断进行自我评估,是对大模型生成内容可信性的重要探索。针对大模型的可解释性方面,已有一些工作试图通过一些探针、对抗攻击、模型可视化等技术来解释大模型的工作过程。此外,大模型正在与显性的知识进行融合,通过对大模型的训练数据进行更多的标注处理,或在大模型预训练或微调阶段引入知识图谱,或在大模型文本生成阶段与知识图谱推理进行结合,均可以提升大模型知识的准确性,并使大模型具有更强的可解释推理能力。

同时大模型在更为复杂场景下的鲁棒性和泛化能力方面也值得探索,大模型并不能适用所有场景,它本质上还是依赖训练数据能覆盖的场景。例如,我们覆盖的场景是一个复杂的小场景,在场景规模数据不大的情况下,不得不去依赖对它进行微调。但是,通过不同细分领域划分成不同类别进行数据有效的筛选、标注,以及相应的微调技术就能使得大模型具有较好的在不同小场景、场景较复杂情况下适用的能力,提升它的可靠性。

此外,大模型脱胎于大数据、大算力,对资源要求很大,训练和部署成本很高,以GPT-3为例,它需要数千GB显存开销,一次训练需要数百万美元。因此,低功耗和高性能的人工智能模型构建,以及新型的人工智能计算芯片的研制,已迫在眉睫。

大模型也会带来一系列社会问题,如:大模型生成的内容,存在一定的伦理、法律、社会安全、价值观等方面的隐患,需要进行针对性政策方面的探索。

4 如何应对大模型技术的挑战

应对大规模技术的挑战,首先,要在抓紧推动大模型技术研发的同时,鼓励交叉原始创新,构建新质人工智能技术。在认识到大模型带来重要机遇的同时,也要充分认识到大模型依然存在一系列关键技术挑战,应着力推动人工智能与脑科学、认知科学的交叉创新研究,力争从人工智能的“可解释性”“高可靠性”和“低功耗性”等方面形成重要突破。

其次,加强人工智能安全技术和伦理治理机制建设。大模型的快速发展,迫切需要加大力度进行人工智能安全检测与防御技术的研发与部署,包括加强针对大模型的数据隐私窃取和保护的技术研发与制度建设。加强大模型生成内容的技术审核与规范构建,构建人工智能生成内容的知识产权保护机制,并进一步强化科技伦理教育,建构用户使用规范。

(参考文献略)

选自《中国人工智能学会通讯》

2023年第13卷 第4期

- 主持人走光(北京这一夜,陈数摔倒走光,闰妮风情万种,主持人翻车陈凯歌不满)

- 张苏军(副区长等4人当“保护伞”被查后,区政协主席也落马了)

- 加油站卖烟吗(加油站抽根烟会咋样?)

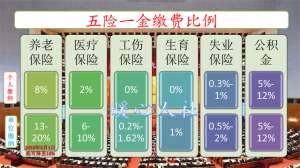

- 挂靠单位交社保(挂靠企业缴纳社保有什么优缺点?和灵活就业相比哪个性价比更高?)

- 京东商家登录(京东商家助手使用方法介绍 网络设置对话框功能说明)

- 济南市统计局(聚焦“项目突破年”济南市统计局将加强对十大领域重点项目开工及建设进度情况监测)

- 陈庆云(有机化学家、中科院院士陈庆云逝世系我国有机氟化学开拓者)

- 杨舒越(cba啦啦队哪个最漂亮?篮球宝贝颜值排行)

- 上海家化(龙头易主,上海家化失去的四年)

- 四平日报(2017,四平日报在做啥?)

- 王命旗牌(说一说清朝的“王命旗牌”和“尚方宝剑”)

- hwm(详解oracle中move的执行机制+通过move操作来降低HWM大小)

-

主持人走光(北京这一夜,陈数摔倒走光,闰妮风情万种,主持人翻车陈凯歌不满)

2015.12.16 -

张苏军(副区长等4人当“保护伞”被查后,区政协主席也落马了)

2015.12.16 -

加油站卖烟吗(加油站抽根烟会咋样?)

2015.12.16 -

挂靠单位交社保(挂靠企业缴纳社保有什么优缺点?和灵活就业相比哪个性价比更高?)

2015.12.16